Sciences et Technologies

Sciences et Technologiesde l´Information et

de la Communication pour

l´Éducation et la Formation

version à télécharger (pdf)

Volume 27, 2020

Article de recherche

Numéro Spécial

Sélection de la conférence

EIAH 2019

|

Contact : infos@sticef.org |

Équiper et évaluer un « certificat de compétences cliniques »

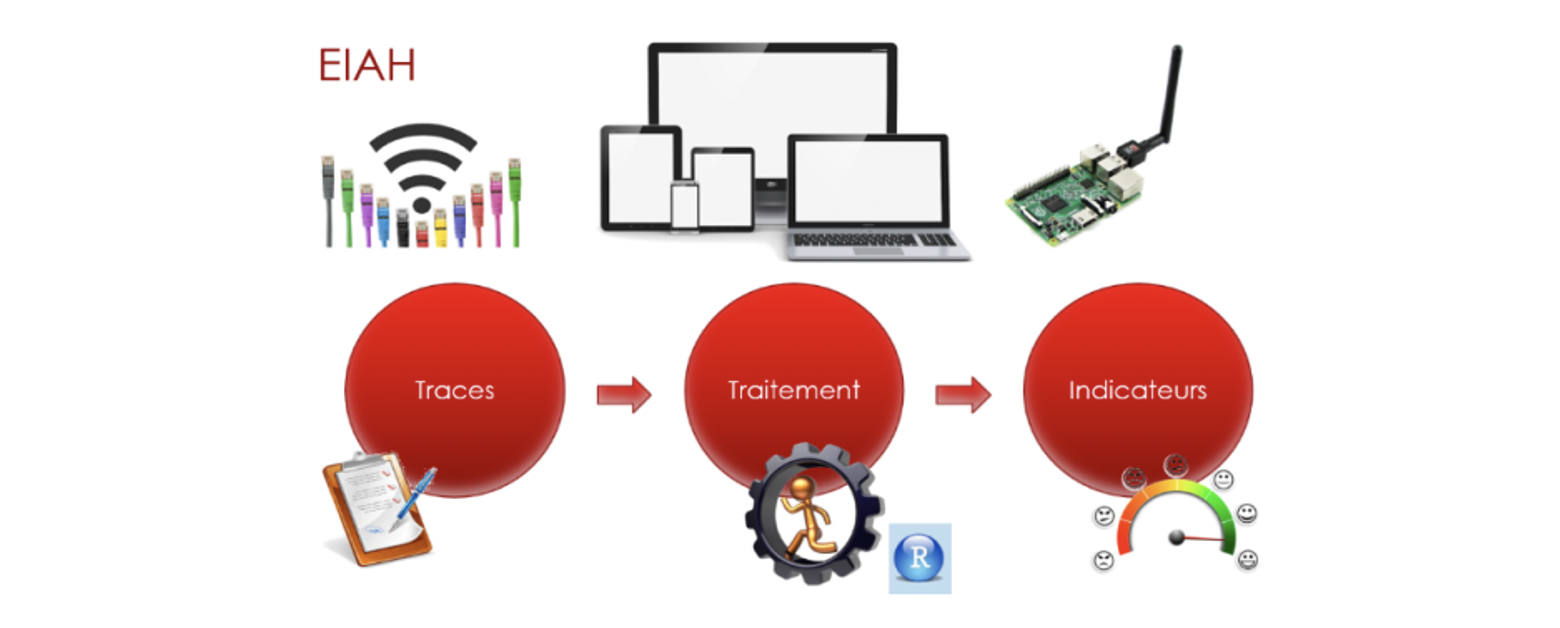

1. IntroductionUn certificat de compétences cliniques a été mis en place depuis 2016 à l’issue du deuxième cycle des études médicales en France (année bac+6). Ce certificat représente une innovation relative pour ce domaine, dans la mesure où il suppose de rompre avec une logique dominante de concours et d’évaluation de connaissances via des questionnaires à choix multiple (QCM), pour évaluer des compétences, en l’occurrence cliniques. Cet article prend appui sur les résultats d’une démarche initiée dans le cadre d’un programme de recherche interdisciplinaire financé par l’Institut de Recherche en Santé Publique (IReSP)1. A travers la conception et la mise en œuvre d’un environnement informatique, il s’agit d’une part d’équiper le dispositif d’évaluation requis pour ce certificat et, d’autre part, de contribuer à un retour réflexif sur le dispositif. Nous exposerons tout d’abord le contexte d’introduction de ce nouveau certificat, ainsi que les conditions de sa mise en œuvre à l’Unité de formation et de Recherche (UFR) de Médecine de Toulouse Purpan. A travers l’analyse des résultats de cet examen, nous montrerons que ce certificat se distingue des autres dispositifs d’évaluation, ce qui conduit à considérer qu’il évalue des dispositions ou des savoirs autres que ceux que mesurent les épreuves classantes. Sur la base de l’analyse des résultats d’examen, qui permet d’en préciser les modalités et attendus, nous proposons une prise de recul : qu’en est-il de ce qui est ainsi évalué ? Tant les retours des étudiants via des questionnaires anonymes, que la mise en discussion des résultats intermédiaires avec ceux d’autres recherches, invitent à interroger les approches pédagogiques qui sous-tendent le dispositif et les acceptions associées des compétences cliniques. Enfin, nous conclurons en proposant des perspectives de recherche. 2. Conditions d’élaboration et mise en œuvre d’un dispositif d’évaluation2.1. Contexte de développement d’un certificat de compétences cliniquesDans le cadre de la réforme des études médicales, la définition d’un référentiel de compétences génériques dans le Bulletin Officiel du 16 Mai 2013 a rendu nécessaire une transformation pédagogique pour mettre en place un processus d'acquisition, de développement et de certification des compétences cliniques en médecine (2ème cycle). Le certificat de compétences cliniques (CCC) a été mis en place pour en assurer la validation (MESRI, 2013) ; les principales compétences attendues sont celles de : « Clinicien », « Communicateur », « Acteur de Santé Publique », « Scientifique », « Responsable aux plans éthique et déontologique », « Réflexif » (les extraits du BO sont présentés en annexe). Beaucoup d’auteurs se sont penchés sur la notion de compétence. Nous utiliserons dans cet article la définition de Tardif : « Un savoir-agir complexe prenant appui sur la mobilisation et la combinaison efficaces d’une variété de ressources internes et externes à l’intérieur d’une famille de situations » (Tardif, 2006). Cette définition souligne le caractère complexe et situé des compétences. Or l’inscription de cette démarche par compétences dans les études médicales vient en tension avec une logique de concours, qui suppose des critères objectifs et « neutres » d’évaluation pour l’interclassement des différents candidats. Cette logique du concours a progressivement transformé les études médicales, en faisant du QCM la modalité prédominante d’évaluation, et l’organisation des enseignements. Le nouveau certificat de compétences cliniques se trouve ainsi « pris en tenaille » entre l’objectif d’évaluer des savoirs complexes, interactionnels et situés, et l’exigence de critères d’évaluation objectivables et standardisables. Nous proposons dans le cadre de cet article de questionner les logiques en tension dans un tel dispositif d’évaluation. Nous verrons qu’une forme première de résolution de ces tensions a consisté à privilégier une approche béhavioriste, focalisée sur des comportements observables et mesurables (Boutin, 2004). Nous poserons ensuite des jalons vers d’autres approches susceptibles de mieux évaluer les compétences mobilisées pour affronter des situations qui réclament une réflexion sur et dans l’action (Boutin, 2000). Le dispositif d’évaluation retenu permet de placer les étudiants en situation professionnelle et constitue une épreuve appelée « Examen Clinique Objectif Structuré » (ECOS), largement utilisée dans les pays anglo-saxons pour la certification des médecins (Khanz et al., 2013a). Les étudiants vont successivement être interrogés en situation clinique au sein d’une station thématique pendant un temps limité de 7 minutes, l’épreuve comptant au total 7 stations. Le choix de ces stations correspond à des compétences dont l’acquisition est indispensable en fin de deuxième cycle des études médicales (6ème année). Avant de décrire les stations, deux éléments doivent être précisés : - la définition d’un patient-standardisé, qui est une personne formée à reproduire de façon standardisée une situation clinique élaborée spécifiquement par l’équipe pédagogique pour évaluer certaines compétences, cette personne est habituellement un comédien ; - l’utilisation des mannequins qui permettent de reproduire des anomalies de l’examen clinique, par exemple une anomalie de l’auscultation cardiaque ou encore une tumeur du sein, dans les stations dévolues à l’évaluation de l’examen clinique. Les deux premières stations de l’épreuve d’ECOS sont les stations «électrocardiogramme (ECG) » et « Thérapeutique ». Elles abordent des situations médicales d’urgence. La station suivante, « Dermatologie » devenue ensuite « Iconographie », utilise un document (photo, radiographie) à analyser dans une situation clinique. La station « Annonce » et la station « Interrogatoire » utilisent un patient-standardisé et évaluent respectivement les aptitudes relationnelles de l’étudiant à délivrer une information au patient ou à solliciter des informations dans le cadre d’une démarche de diagnostic. La station « Clinique » utilise un mannequin permettant d’évaluer l’étudiant.e en situation d’examiner un patient. La station « Examens complémentaires » évalue la pertinence d’une demande d’examen complémentaire dans une situation clinique et son interprétation. Enfin la station « Synthèse » permet à l’étudiant.e d’argumenter l’ensemble de la démarche concernant les stations « Interrogatoire », « Clinique » et « Examens complémentaires » ; seule cette station comporte deux examinateurs. A chaque station, l’examinateur utilise des grilles critériées qui visent à favoriser l’homogénéité de l’évaluation (Khanz et al., 2013b). En parallèle à la mise en place du nouveau dispositif d’évaluation, le dispositif pédagogique global a été modifié afin de permettre la formation des étudiants à ces nouvelles modalités d’évaluation, incluant en particulier des séances de simulation avec des patients-standardisés telles que pratiquées dans deux stations de l’examen, ou encore la formation à l’examen clinique ou à certains gestes sur mannequin pendant l’ensemble de leur cursus. 2.2. MéthodologiePour la mise en œuvre de cet examen, un environnement informatique a été mis en place. Il est représenté sur la figure 1. Son rôle est de recueillir les données d’évaluations, d’automatiser et d’accélérer leurs traitements, pour faire une remontée des résultats plus rapidement. L’environnement, essentiellement composé à ce stade de grilles d’évaluation, permet de collecter sous forme de traces brutes un ensemble d’éléments observés. Côté front office, le recueil de données se fait au travers d’une application web responsive permettant aux évaluateurs de saisir leurs résultats.

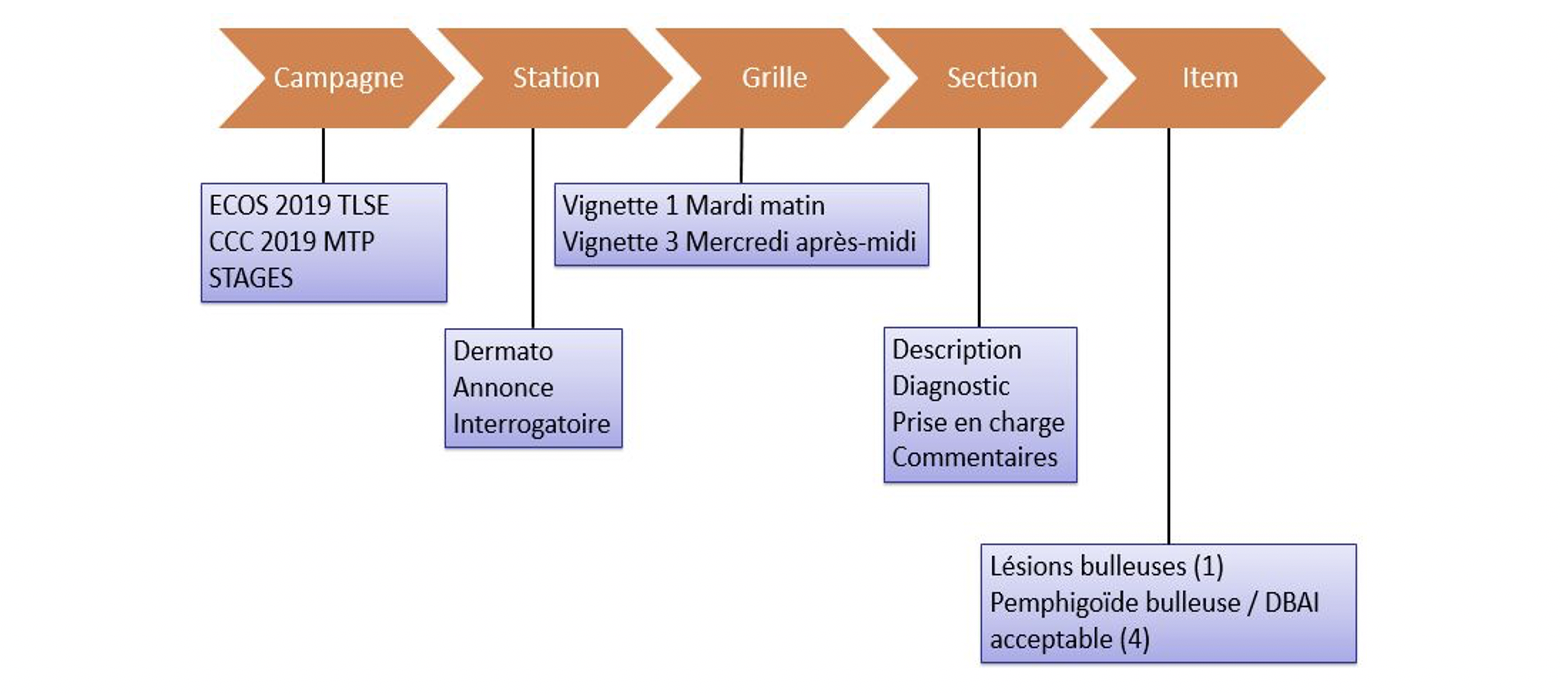

Le certificat de compétences cliniques est organisé dans les locaux de l’Institut Toulousain de SIMulation en Santé (ITSIMS) qui dispose d’une infrastructure hétérogène. Les utilisateurs peuvent être amenés à utiliser l’environnement informatique aussi bien à partir de postes fixes reliés au réseau filaire, que de PC portables ou de tablettes reliés au WiFi. Quelques salles d’examen ne disposent ni de connexion filaire ni d’une qualité de réception suffisante du WiFi, il a fallu alors installer des systèmes autonomes : bornes WiFi avec portail captif vers une version hors ligne de l’environnement informatique. Les données collectées ont été transférées toutes les demi-journées sur le serveur central. Les étudiants ont parfois dû utiliser leur téléphone portable avec connexion 4G pour répondre au questionnaire anonyme de fin d’examen. Le système permet de gérer plusieurs campagnes d’évaluation (une par année, cf. figure 2). A chaque campagne sont rattachées les 7 stations. Pour chaque station, entre 16 et 30 grilles d’évaluation sont créées pour éviter la communication des sujets entre étudiants. Il est possible de créer des grilles spécifiques pour la gestion de questionnaires anonymes. Chaque grille est découpée en 3 ou 4 sections contenant les items à évaluer.

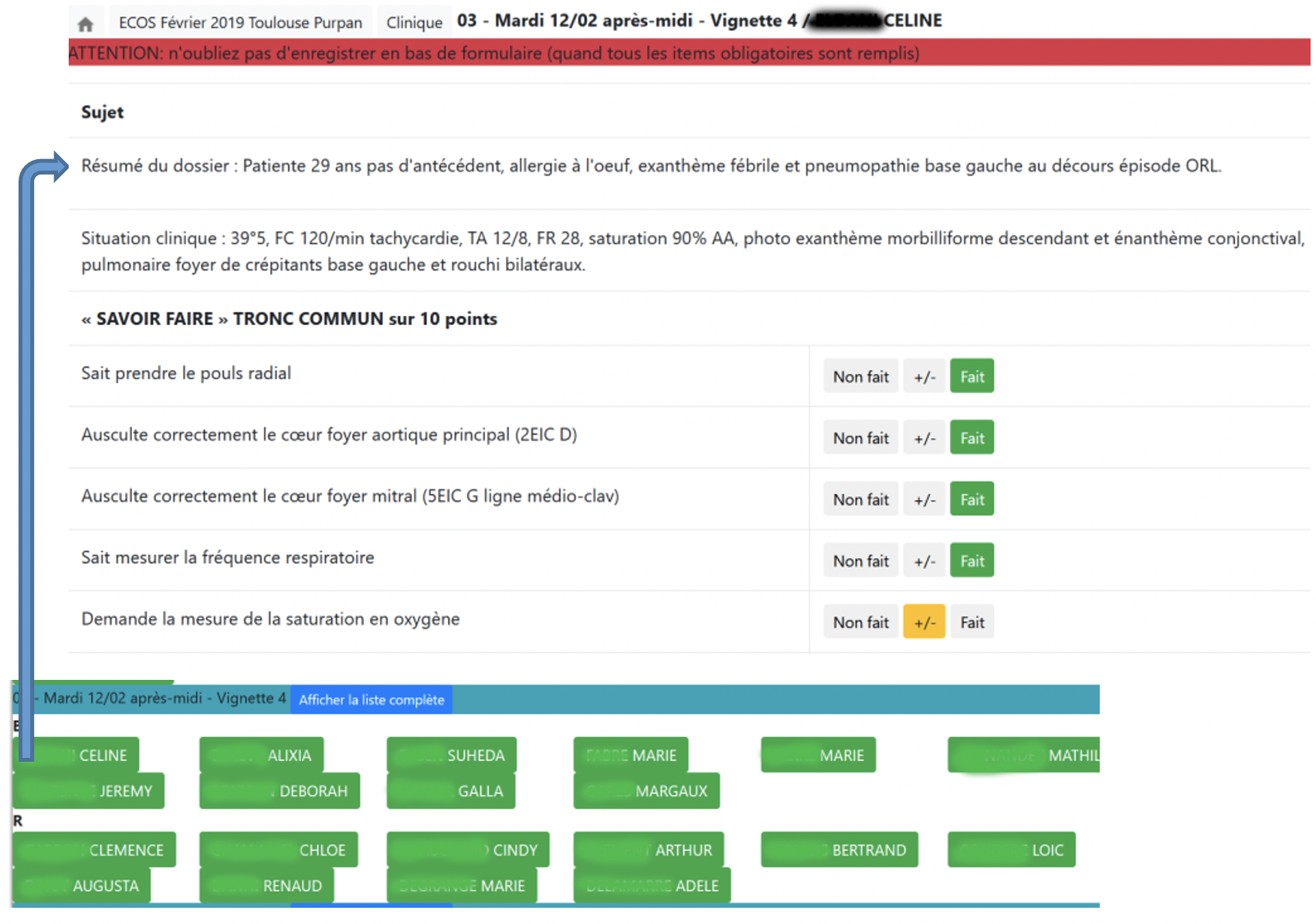

À chaque campagne on associe une cohorte d’étudiants. Pour chaque station, le passage de chaque étudiant sur une des grilles est défini à l’avance en tenant compte des parcours (2 étudiants différents peuvent en effet être examinés au même moment par des jurys différents). L’examinateur n’a plus qu’à préciser (1) la station sur laquelle il travaille et (2) l’étudiant qui se présente à lui pour pouvoir compléter la grille d’évaluation (cf. figure 3).

Figure 3 • Évaluation des étudiants Chaque clic sur une case d’évaluation fait l’objet d’une trace brute envoyée au back office. Une fois collectées, les traces sont modélisées dans le back office, puis des algorithmes de calcul sont mis en place pour produire des indicateurs (Djouad, 2013). Les principaux indicateurs à destination des responsables de formation concernent la réussite à l’examen, le taux de satisfaction des enseignants, le taux de satisfaction des étudiants, le taux de difficulté perçue, mais également d’autres indicateurs qui prennent appui sur une analyse statistique et docimologique des grilles d’évaluation et des résultats associés (Dessus, 2019). Une des finalités est de vérifier la pertinence du dispositif d’évaluation et de l’améliorer pour les futures sessions. La vérification de la pertinence du dispositif s’effectuera par une analyse descriptive des résultats (mesures de position et de dispersion des différents résultats) enrichie par une analyse de la corrélation avec d’autres méthodes d’évaluation (Lecoutre, 2016) telles que les épreuves théoriques de 6ème année et les épreuves classantes nationales (ECN). Enfin l’analyse peut être affinée au moyen de techniques d’analyse en composantes principales (Husson et al., 2016). En effet une faible chute d’inertie caractérise une isotropie des résultats pour les différentes composantes de l’évaluation et par conséquent une homogénéité globale des résultats. Les principaux indicateurs à destination des étudiants relèvent de la rétro-information : réussite à l’examen, commentaires des évaluateurs, évaluation et commentaires des personnes assurant le rôle de patients-standardisés. Lorsque des indicateurs nécessitent des calculs statistiques (par exemple, coefficient de corrélation), le back office sollicite l’application R version 3.5.0 (2018-04-23). Le certificat de compétences cliniques n’a pas à ce stade finalité à participer à l’interclassement des étudiants, mais à vérifier la maitrise de compétences associées à la pratique clinique. Il ne s’agit pas de reproduire la logique « concours » de la Première Année Commune des Études de Santé (PACES) ou des ECN en favorisant des critères discriminants ; la priorité est donnée à l’homogénéité des grilles d’évaluation. L’environnement informatique constitué permet par ailleurs de recueillir de façon anonyme les retours tant des enseignants que des étudiants. La réflexivité ainsi proposée aux étudiants est un appui important pour accompagner l’apprentissage et questionner plus avant les compétences attendues et évaluées. 2.3. ExpérimentationA l’UFR de Médecine de Toulouse Purpan, le CCC a donné lieu à une nouvelle modalité d’évaluation sous forme d’un ECOS à destination des étudiants de 6ème année. L’examen a concerné 141 étudiants en janvier 2016, 134 étudiants en février 2017, 138 en 2018 et 151 en 2019. En 2016 et 2017, les étudiants sont passés successivement par les 7 stations suivantes : « ECG, Dermatologie, Thérapeutique, Annonce, Interrogatoire, Examen clinique, Synthèse ». Ces stations formalisent des étapes standards de la pratique clinique. Il s’agit en particulier d’évaluer la capacité à mettre en œuvre un examen clinique et à formuler des hypothèses de diagnostic et/ou de prise en charge. Un lien est établi entre plusieurs stations pour envisager un même cas à différentes étapes de la démarche clinique. L’ensemble des données collectées et analysées est résumé dans le tableau 1, qui schématise également les évolutions du dispositif. Tableau 1 • Effectifs collectés et analysés de 2016 à 2019

Fusion des stations « ECG » et « Thérapeutique »

Création de la station examen complémentaire

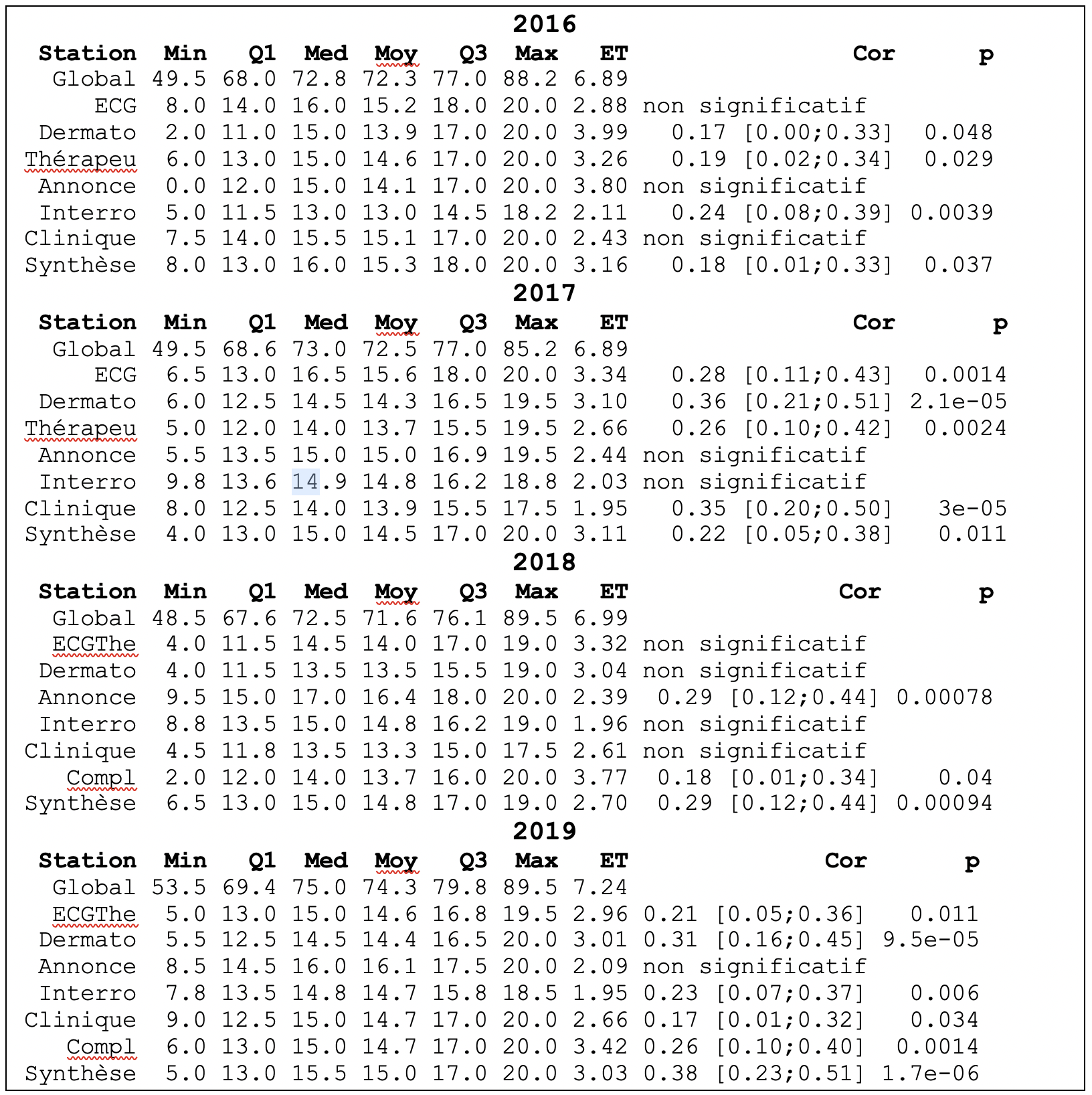

L’environnement informatique n’a été mis en place qu’en 2017 mais une analyse statistique a pu être effectuée a posteriori sur les résultats de 2016. La logistique de l’examen, organisé sur 4 demi-journées, est assez lourde avec environ 25 examinateurs mobilisés, certains participant à plusieurs demi-journées. Chaque étudiant doit passer 7 minutes par station. Le changement de station se fait au coup de sifflet. Chaque station dispose de plusieurs « vignettes » ou sujets d’examens pour éviter la communication entre les étudiants qui ont terminé leur parcours et ceux qui ne sont pas encore passés. En 2018, le contenu de certaines stations a été modifié pour tenir compte des retours des enseignants : les thématiques « ECG » et « Thérapeutique » ont été regroupées en une seule station. De plus, une nouvelle station « Examen complémentaire » a été introduite à la suite de l’examen clinique. C’est une autre caractéristique de ce dispositif que d’être réflexif et de supposer un environnement informatique qui équipe cette réflexivité et qui soit aisément évolutif tout en assurant des formes de comparabilité des résultats. Les capacités mises en œuvre dans les interactions médecin / patient sont plus particulièrement considérées au cours de deux stations faisant intervenir des comédiens comme patients-standardisés (« Annonce » et « Interrogatoire »). Sur chaque station les examinateurs disposent d’une grille d’évaluation informatisée. Les grilles des stations « ECG », « Dermatologie » et « Synthèse » sont composées de 10 à 20 critères évalués entre 1 et 6 points. Les autres grilles sont composées de 10 à 30 éléments pour lesquels l’évaluateur indique s’ils ont été effectués complètement, partiellement ou pas du tout. Le rythme de passage contraint le temps passé par les enseignants à évaluer. Il suppose un environnement informatique très robuste et soulève des défis quant à sa conception et son évolution pour combiner efficacité et pertinence. Un travail exploratoire a été mené par les responsables pédagogiques afin de tenter de mettre en correspondance, d’une part, les éléments d’évaluation et, d’autre part, les compétences génériques définies dans l’annexe du BO pour décrire les compétences génériques dont l’acquisition est nécessaire pour l’obtention du certificat : Clinicien, Communicateur, Acteur de Santé Publique, Scientifique, Responsable aux plans éthique et déontologique, Réflexif (Ministère de l’enseignement supérieur, de la Recherche et de l’Innovation, 2013). En fin de parcours, l’avis des étudiants et des enseignants a été collecté, sur une base volontaire et anonyme, au travers de questionnaires qui leur étaient dédiés. Par ailleurs, des entretiens semi-directifs ont été menés avec des étudiants, sur une base volontaire, concernant leur formation à la relation médecin-patient, avec des questions plus spécifiques relatives à cet examen. Cette base d’informations est centrale pour la recherche ici menée dans la mesure où elle permet de recueillir des avis indépendants du contexte de l’examen. Ce dernier est en effet achevé au moment où il est proposé aux étudiants de prendre quelques instants pour répondre, ce que la plupart d’entre eux font bien volontiers (100 % de participation en 2017, 95 % en 2018, 93 % en 2019), ce moment constituant une forme de sas de sortie d’examen. 2.4. RésultatsL’environnement informatique a permis de diffuser aux candidats les résultats à l’examen en 2017, 2018 et 2019 beaucoup plus rapidement qu’en 2016, en évitant un traitement manuel et potentiellement source d’erreurs. Les questionnaires post-évaluation montrent un intérêt pour la démarche, tant de la part des étudiants que des enseignants-examinateurs. En 2017, le taux de satisfaction du processus d’évaluation pour les enseignants était de 100 % (100 % également en 2019), il était de 92 % pour les étudiants (98 % en 2018, 94 % en 2019). À 76 % les étudiants ont trouvé que l’examen était adapté par rapport à la durée et au niveau demandé (92 % en 2018, 85 % en 2019). En 2017, la station dite « Annonce » (au cours de laquelle une pathologie doit être annoncée au patient standardisé) était perçue comme étant la plus difficile par les étudiants (64 % de taux de difficulté). Les compétences mises en jeu dans la relation soignant-patient, domaine encore peu enseigné au cours des études médicales, sont plus particulièrement mises à l’épreuve dans de tels contextes. La situation a évolué en 2018, la station « Annonce » ayant été mieux préparée avec la mise en place d’enseignements dédiés. Par ailleurs les situations d’annonce ont été simplifiées, en portant sur des annonces d’examen et non directement de pathologie. Le taux de difficulté perçue par les étudiants a alors diminué à 44 % en 2018, 49 % en 2019 alors que la station « Examen clinique sur mannequin » a été perçue comme étant la plus difficile (44 % de taux de difficulté en 2017, 49 % en 2018, 52 % en 2019). Des éléments d’explication peuvent tenir aux limites techniques des mannequins et au manque d’entrainement des étudiants dans ce contexte. Le retour sur évaluation était très attendu par les étudiants. Les résultats de chaque station ont été communiqués par groupe de critères. Exemples : Savoir Etre, Diagnostic, Prise en Charge, Raisonnement... Les commentaires saisis par les évaluateurs étaient également communiqués. De plus, sur les 2 stations où intervenaient des acteurs jouant le rôle de patient-standardisé (« Annonce » et « Interrogatoire »), une évaluation formative du candidat leur était demandée. Le résultat de cette évaluation était communiqué aux étudiants, mais ne rentrait pas dans le calcul de la note finale pour l’attribution du certificat de compétences cliniques. Cette évaluation pourrait toutefois devenir sommative à l’avenir. En 2017, la corrélation entre l’évaluation formative des acteurs et l’évaluation sommative des enseignants sur le savoir être des étudiants n’était que de 0.39 pour l’Annonce (p=3.4e-6) et de 0.31 pour l’Interrogatoire (p=2.427e-4). Il y a là un élément intéressant à investiguer plus avant pour expliciter, d’une part, les attendus des enseignants et, d’autre part, ceux des acteurs jouant les patients-standardisés qui ont été formés au feedback. L’examen n’avait pas de visée sélective, et cela s’est confirmé par la réussite de la quasi-totalité des étudiants, seuls un à deux passant chaque année à la session de rattrapage. Une analyse statistique plus fine des résultats, résumée dans le tableau 2, montre que chaque station a son utilité dans le dispositif. Les résultats sont calculés de la manière suivante : le score de chaque station est obtenu en faisant la moyenne pondérée de tous les éléments évalués lors du passage de l'étudiant sur la station. Les résultats sont présentés sur un barème de 20 points par station. Un élément effectué complètement rapporte 1 point, un élément effectué partiellement rapporte un demi-point et un élément non effectué ne rapporte pas de point. Le score global est obtenu sur un barème de 100 points en faisant la moyenne pondérée des 7 stations. Prenons l'exemple de la station Dermato en 2016, le coefficient de corrélation est calculé entre (1) les résultats de cette station et (2) la somme des résultats des six autres stations. La normalité des résultats a été vérifiée. Pour chaque calcul de coefficient de corrélation, la méthode suivante a été appliquée : (1) vérification que l'allure de l'histogramme des variables est sous forme de cloche, (2) vérification que l'allure du diagramme quantile-quantile est sous forme de droite de pente égale à 1, et (3) élimination des valeurs isolées (inférieures à Q1 - 1.5(Q3-Q1) et supérieures à Q3 + 1.5(Q3-Q1)). Les coefficients de corrélation calculés entre les résultats des grilles d’une station donnée et les résultats des grilles des autres stations, quand ils sont significatifs, restent positifs et faibles (entre 0.17 et 0.24 en 2016 ; entre 0.22 et 0.36 en 2017 ; entre 0.18 et 0.29 en 2018 ; entre 0.17 et 0.38 en 2019) justifiant ainsi de l’intérêt de chaque station. Tableau 2 • Analyse statistique des résultats des différentes stations

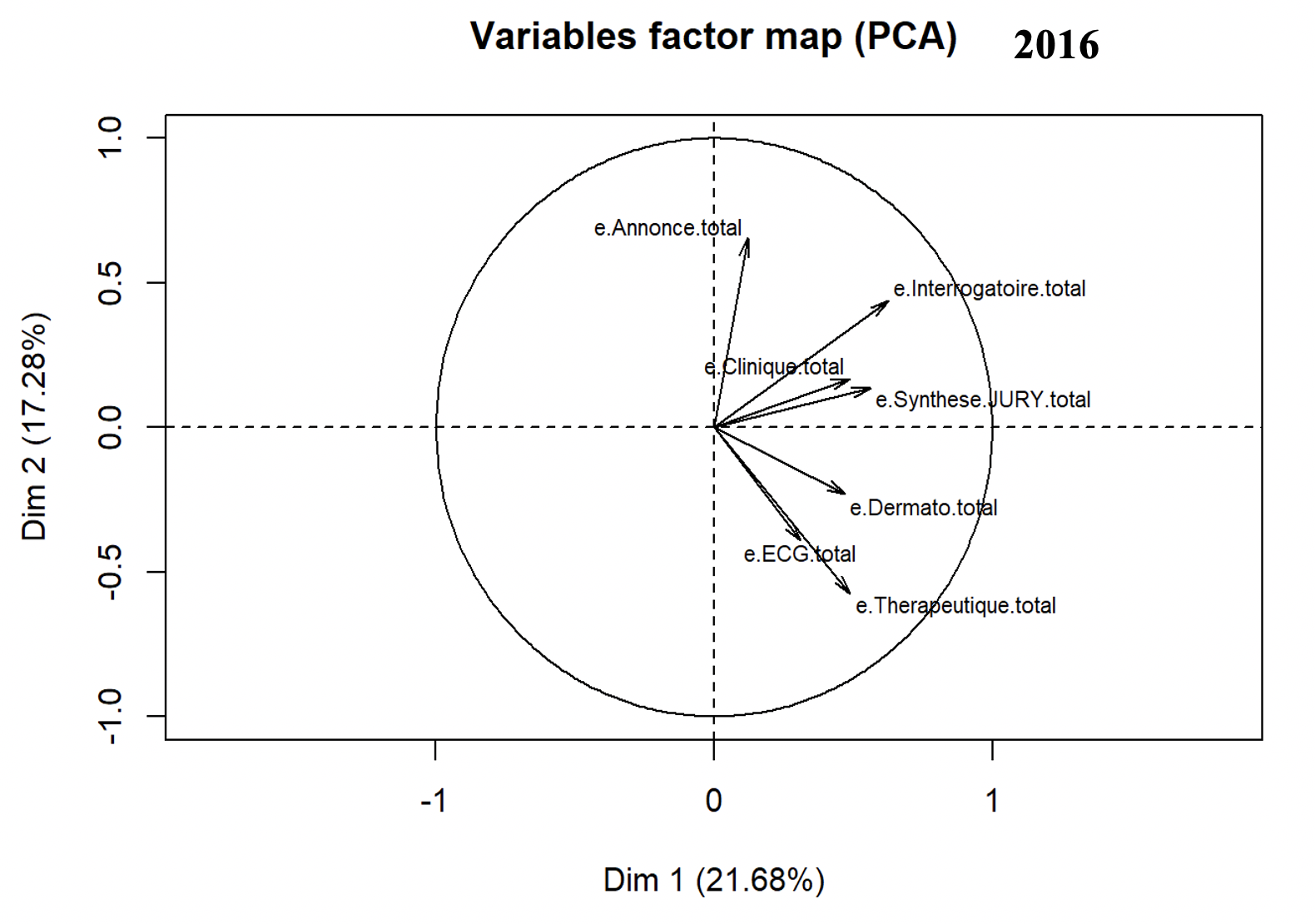

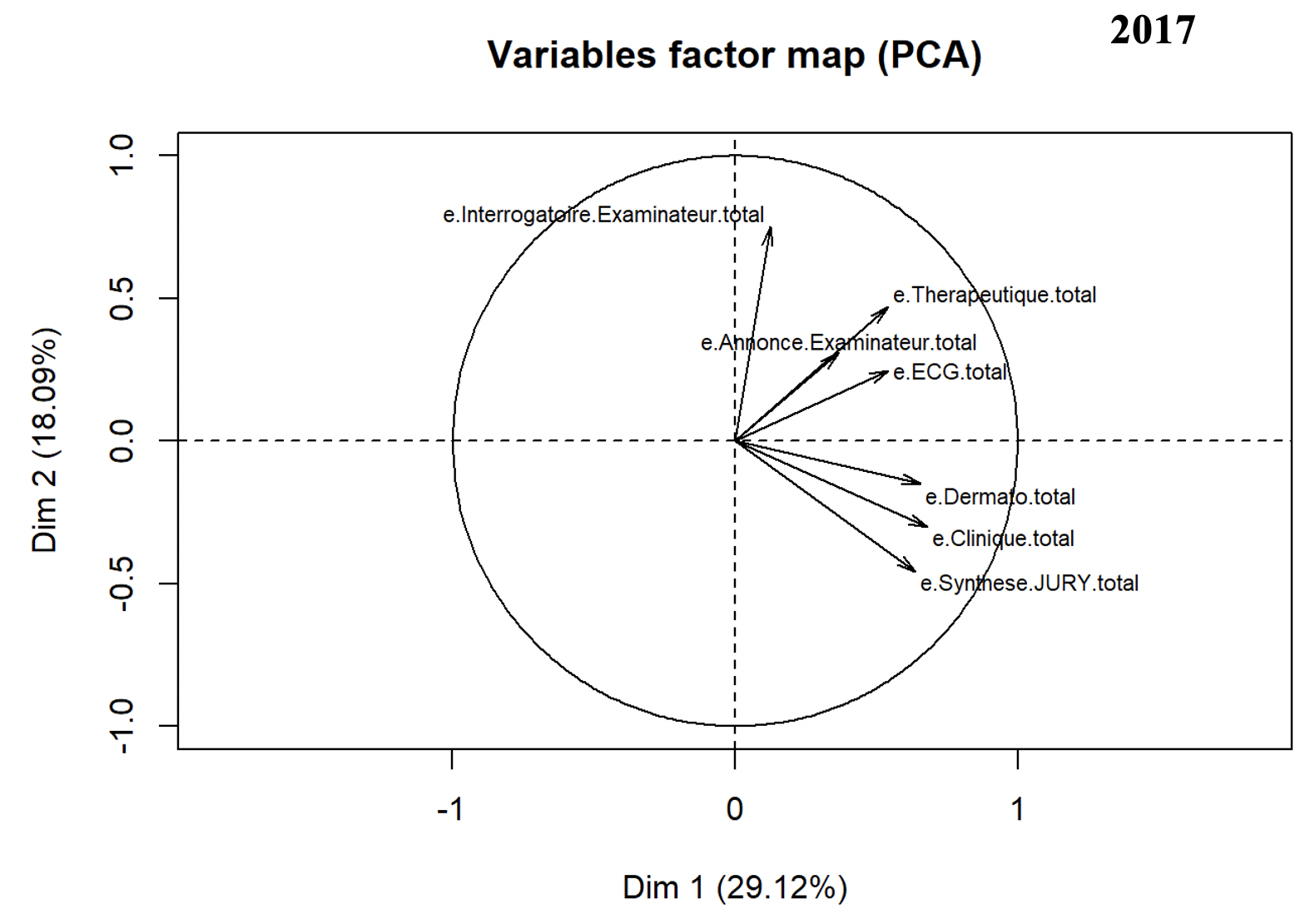

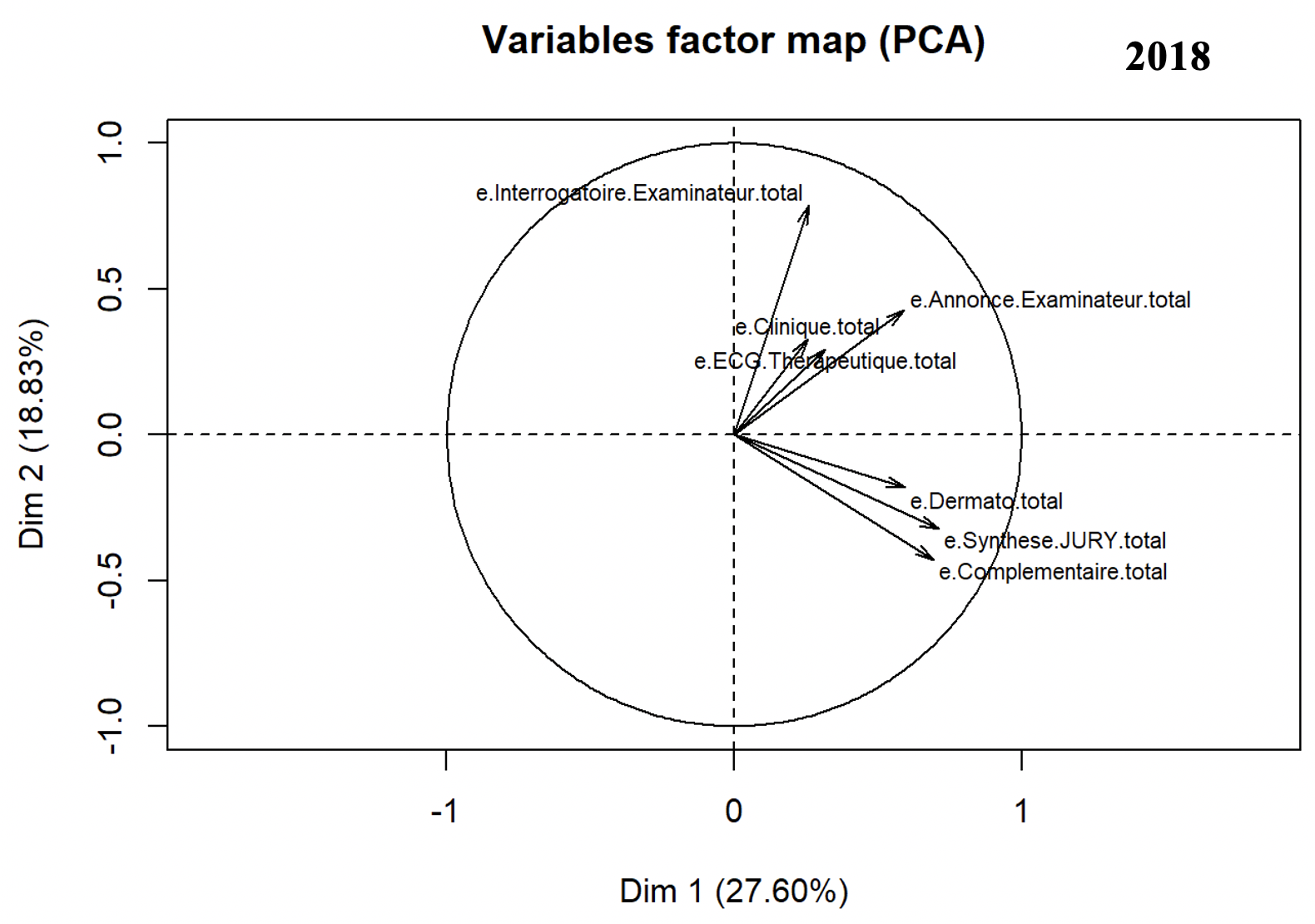

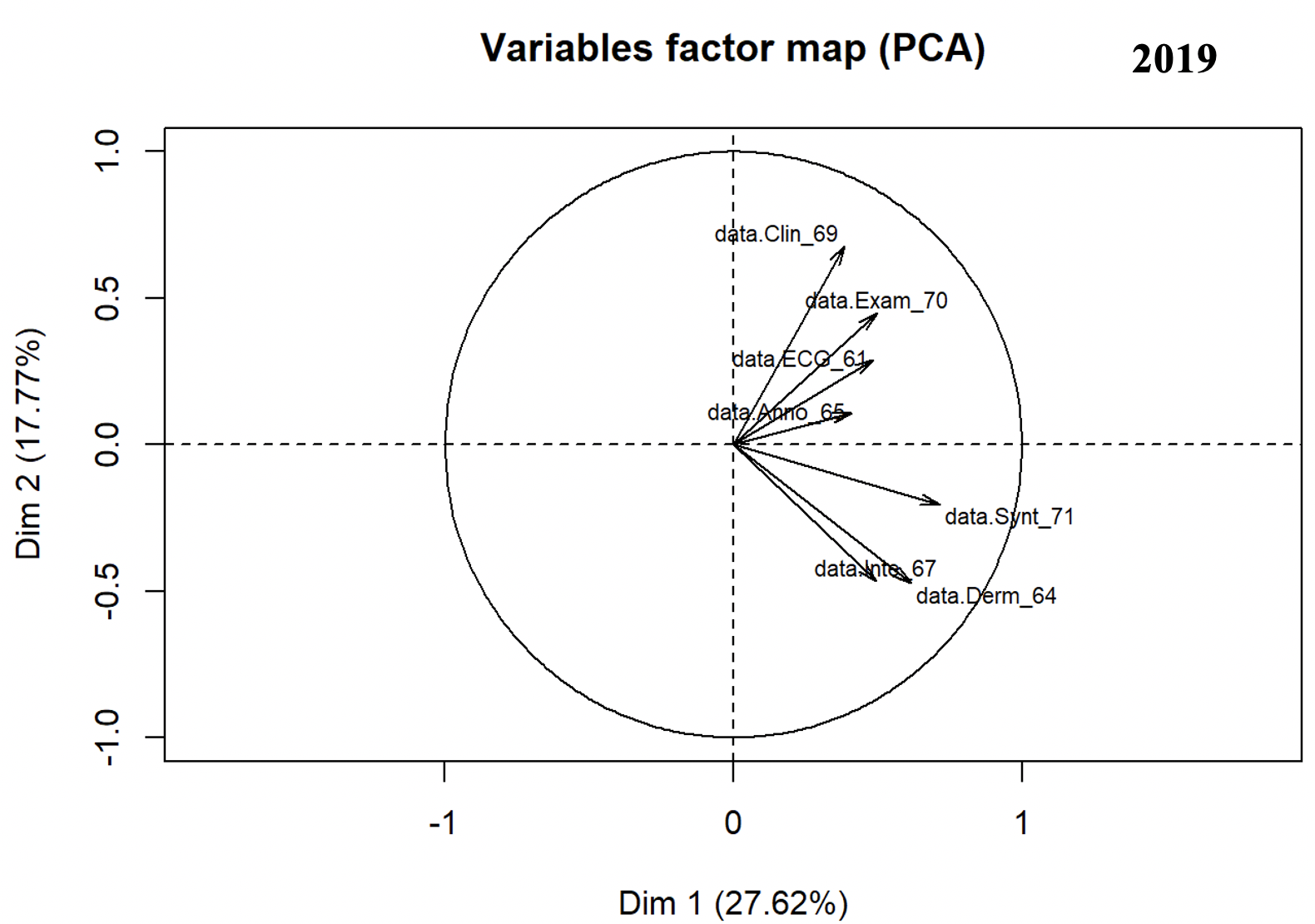

La faible dispersion des résultats montre également l’homogénéité de ces derniers. Une analyse en composantes principales indique une chute d’inertie faible (39 % de l’information sur les 2 premières dimensions en 2016, 47.21 % en 2017, 31.88 % en 2018, 45.39 % en 2019, cf. figure 4). Là encore, on retrouve une homogénéité, il n’y a pas de caractère discriminant entre les stations.

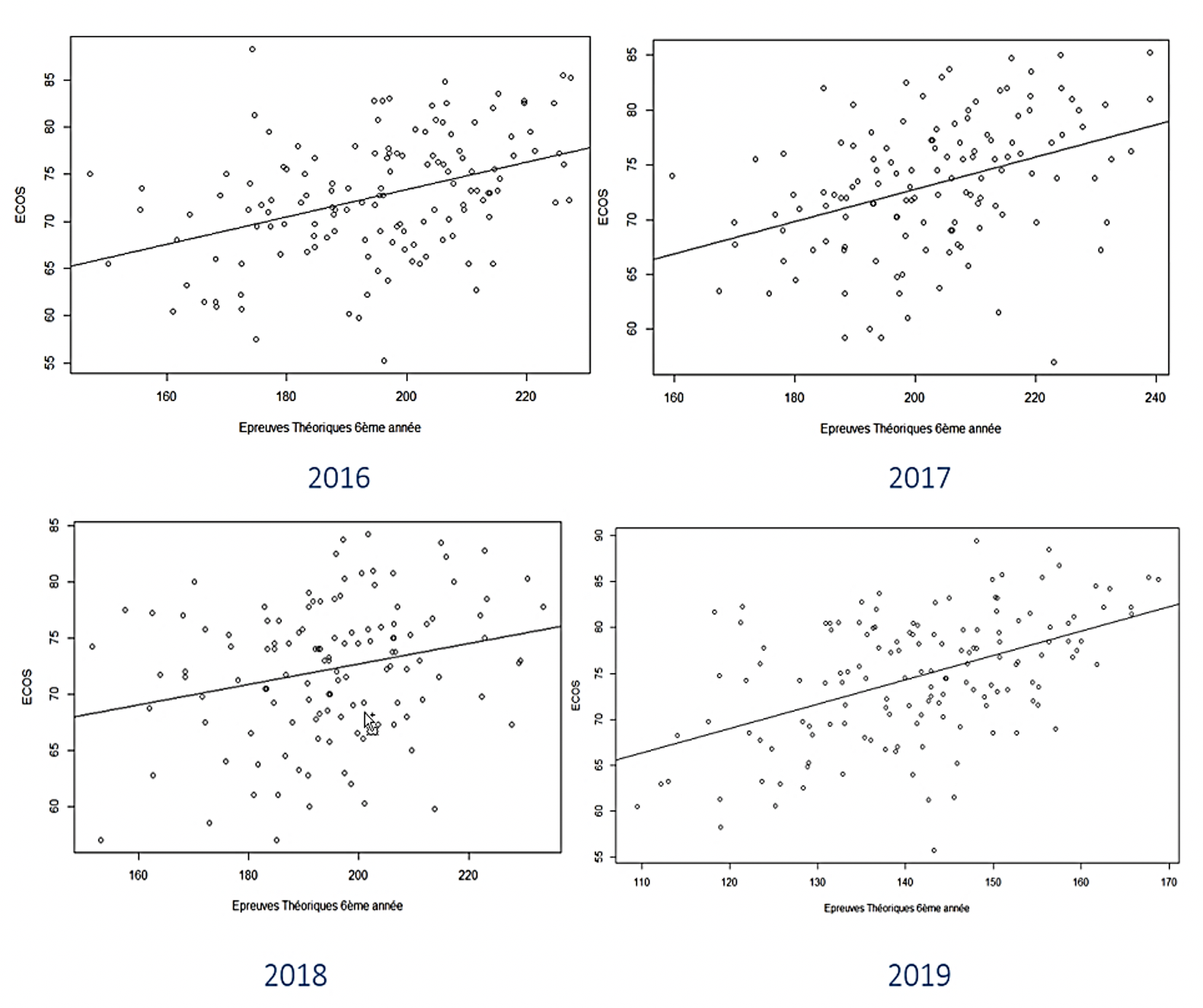

Figure 4 • Cercles des corrélations issus de l’analyse en composantes principales des données Il n’y a pas non plus de redondance avec les résultats aux épreuves théoriques. En effet, comme le montre la figure 5, le coefficient de corrélation entre les résultats à l’ECOS et les résultats de l’UE d’enseignements théoriques de 6ème année est également significatif, positif et faible (0.40 [0.25;0.53] en 2016, 0.39 [0.23;0.53] en 2017, 0.25 [0.08;0.41] en 2018, 0.49 [0.36;0.61] en 2019) justifiant de l’intérêt de l’ECOS par rapport aux modalités d’évaluation classiques existantes. La modification des stations en 2018 apporte une tendance à la diminution de la corrélation mais ceci n’est pas vérifié sur les résultats 2019.

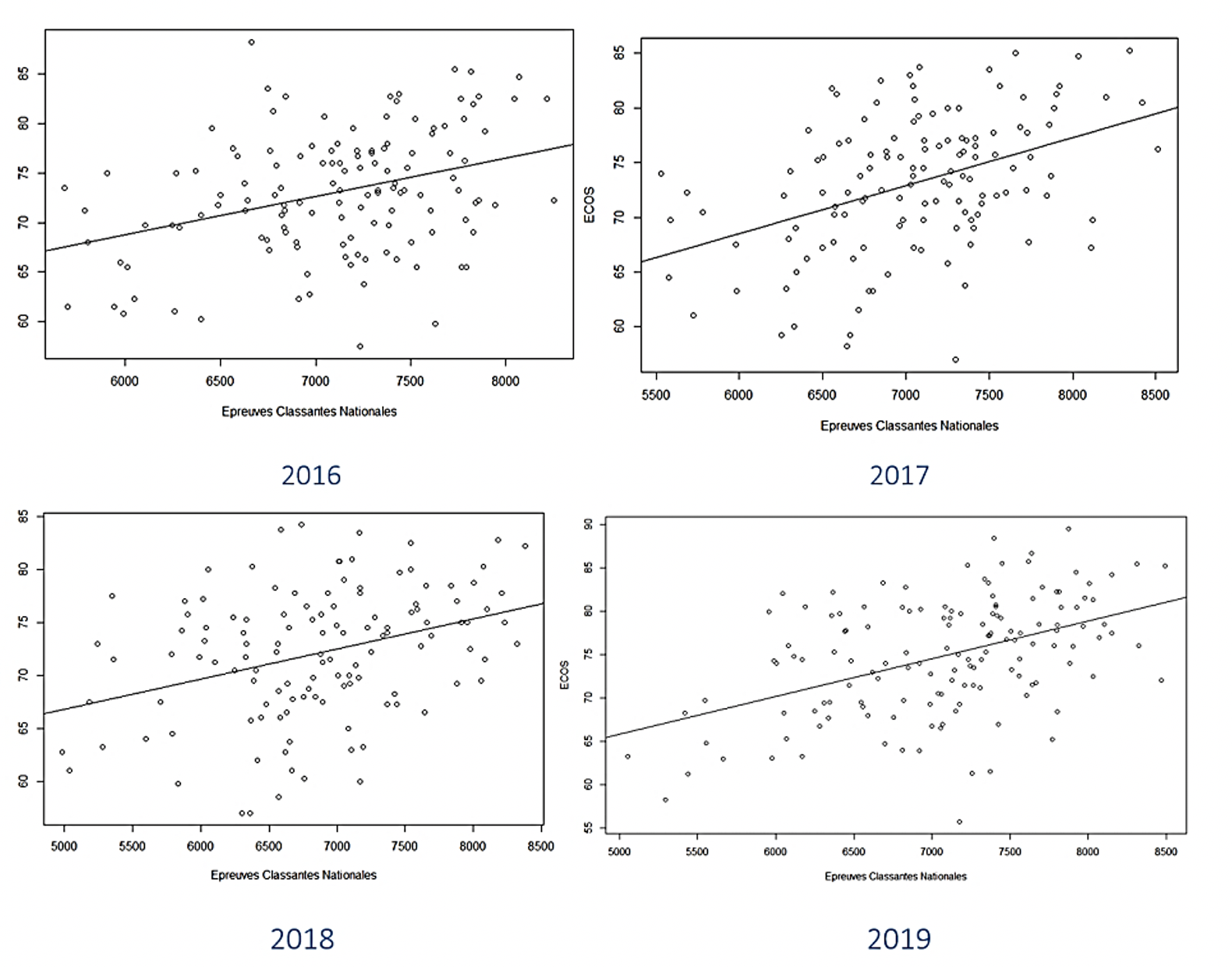

Enfin, il n’y a pas de redondance avec les ECN. En effet, le coefficient de corrélation entre les résultats à l’ECOS et les résultats des épreuves classantes nationales est lui aussi significatif, positif et faible (0.35 [0.19;0.49] en 2016, 0.43 [0.27;0.56] en 2017, 0.35 [0.19;0.50] en 2018, 0.46 [0.32;0.58] en 2019, cf. figure 6). Ainsi l’examen ECOS présente une contribution spécifique qui peut être associée notamment à la mise en situation.

Figure 6 • Nuage de points de l’ECOS et des épreuves classantes nationales Tous ces résultats mettent en évidence l’intérêt de la démarche en ce que l’évaluation qui en résulte n’est pas redondante par rapport à d’autres dispositifs d’évaluation. Nous allons maintenant prendre un peu de recul au regard de ce qui peut être appréhendé comme une évaluation priorisant des critères d’évaluation objectivables et standardisables dans une approche à dominante behavioriste. 3. Analyse critique3.1. Compétences/critères d’évaluation : des catégorisations distinctes et complexes à mettre en cohérenceL’annexe du BO (MESRI, 2013) décrit les compétences génériques requises en les articulant autour de 7 compétences (voir l’extrait du BO présenté en annexe de cet article). Mais il ne donne pas d'indication sur la façon dont ces compétences doivent être spécifiées et évaluées. C’est cette évaluation que vise cet examen, notamment concernant les compétences génériques de « clinicien » et « communicateur », tout au long des 7 stations. Quelles conceptions sont alors retenues des attendus et des modalités pour les atteindre ? En termes de ressenti, 87 % des enseignants ont estimé que la formation actuelle permet aux étudiants d’acquérir les compétences requises. Cependant, il ne leur était pas demandé quelles étaient leurs définitions de ces compétences. Les étudiants sont beaucoup plus circonspects, quand on les interroge sur la maitrise de chacune des 7 compétences génériques dans le cadre du questionnaire anonyme soumis après achèvement du parcours des stations d’évaluation : les taux de maitrise déclarée varient de 47 % pour les compétences « d’acteur de santé publique » à 55 % pour celles de « coopérateur ». On retrouve cette tendance en 2018 : les taux de maitrise déclarée varient de 50 % pour les compétences « d’acteur de santé publique » à 57 % pour celles de « coopérateur ». De même en 2019, les taux de maitrise déclarée varient de 47 % pour les compétences « d’acteur de santé publique » à 64 % pour celles de « coopérateur ». Les étudiants concernés n’avaient découvert que tardivement ces différentes compétences génériques telles qu’énoncées, auxquelles ils n’avaient été sensibilisés que quelques semaines avant l’examen ; ces réponses traduisent également une difficulté de compréhension des attendus, tant les termes sont vastes et les définitions étendues. La question se pose du passage des compétences à des actions susceptibles d’être évaluées. Selon Rey, un référentiel (tel celui décrit dans le BO pour les compétences génériques) devient parole de commandement, mais ne garantit pas la faisabilité, surtout quand on aborde le caractère civique et social (Rey, 2015). Rey interroge la culture du résultat susceptible d’y être associée : il y a souvent, dans nombre d’approches par compétences, confusion entre la compétence et le résultat d’une action qui s’apparente alors à une performance. A titre d’exemple, les compétences génériques de communicateur requièrent de la part de l’étudiant qu’il soit à même « d’établir une communication axée sur le patient, par le biais de la prise de décisions partagées et d’interactions efficaces fondées sur l’éthique et l’empathie ». Or, il reste difficile de formuler des critères d’évaluation au-delà des formules de politesse et de civilité usuelles. Le BO laisse la mise en œuvre du référentiel sous la responsabilité des enseignants et des étudiants et fait quasi-silence sur le processus d’engendrement de ces compétences et de leur évaluation ; seules les modalités « d’évaluations en situation authentique et des auto-évaluations » sont évoquées. 3.2. Priorités aux critères formels et limites d’une approche béhavioristeRoegiers souligne l’importance d’établir une articulation entre le référentiel métier, le référentiel de compétences et le référentiel de formation initiale (Roegiers, 2010). Le Boterf ajoute la nécessité d’élaborer préalablement un référentiel d’évaluation (Le Boterf, 2011). On sent bien que la volonté ministérielle d’introduire l’approche par compétences dans les études de médecine n’en est qu’au début de la démarche. La mise en œuvre de l’ECOS l’est également. Les critères d’évaluation ont été définis de manière empirique. La priorité donnée à l’opérationnel pour faire face aux défis de l’ingénierie pédagogique a conduit à mettre, en partie, de côté la réflexion sur les conceptions des relations soignants-patients et leurs modes d’enseignement. Dans la définition de la compétence par Tardif, figure la notion de « famille de situations ». Cela interroge à deux niveaux par rapport à l’évaluation proposée : la répétition et la complexité. D’une part, cela sous-entend que la compétence ne peut être acquise que si elle a pu être mobilisée dans plusieurs situations. Quel crédit peut-on alors donner à une certification qui ne repose que sur une situation unique (celle de l’examen) ? Une réflexion est actuellement en cours pour étendre le dispositif d’évaluation (formative et sommative) aux situations de stage de la 2ème à la 5ème année de formation. D’autre part, dans une famille de situations, certaines seront plus complexes à traiter que d’autres. On se retrouve alors face à un paradoxe : les « vignettes » sont construites sur des situations simples et courantes du point de vue des médecins pour répondre aux attendus en fin de 2ème cycle. Mais cela ne conduit-il pas à une conception réductrice de ce que seraient les compétences cliniques, recentrées sur l’interrogatoire, l’examen et la prescription sur un patient standardisé objet des soins ? Il est en cela utile d’interroger la posture béhavioriste qui sert souvent de fondement à l’approche par compétences. Comme le souligne Boutin, le béhaviorisme est adapté pour la maitrise de comportements observables, objectivés. Dans cette approche, « le comportement visé doit être répété jusqu’à ce qu’il devienne automatique » (Boutin, 2000). Ainsi en est-il lors d’examens cliniques de l’identification de certains signes cliniques. Leung montre les dérives d’une approche qui peut, dans son principe de répétitivité étendue à l’évaluation, tendre à l’absurdité (Leung, 2002) : il donne l’exemple d’un étudiant qui doit montrer au moins 4 fois qu’une compétence est mise en œuvre au cours de 7 situations filmées différentes. Meirieu critique ce qui peut se traduire par l’atomisation des apprentissages globaux en une multitude de petits actes dont la recomposition peut être difficile (Meirieu, 2005). Hébrard (Hébrard, 2011) souligne quant à lui le risque qu’il y aurait à privilégier l’apprentissage par l’action en situation, au détriment des connaissances, des concepts et cadres d’analyse relevant des disciplines. Dans la formation d’infirmier, il constate que les grilles d’évaluation des compétences sont souvent hétérogènes et sont constituées d’une liste de preuves à vérifier ; les évaluateurs font alors face à la difficulté de cocher telle ou telle case. De plus, les dimensions affectives, conflictuelles, la question du pouvoir et les enjeux identitaires sont occultés. Dans les études médicales, les connaissances issues des sciences sociales sont en bonne part ignorées, l’enseignement étant essentiellement le fait de praticiens. Or, l’approche par compétences, si elle est ramenée à une liste d’activités, ne permet pas de prendre en compte ce qui est identifié comme une caractéristique clé du travail de thérapeute. Le travail de thérapeute est en effet caractérisé par une tension intrinsèque entre, d’une part, un mouvement nécessaire d’objectivation du patient pour interpréter les signes éventuels de la maladie, et d’autre part une capacité à « se déprendre de sa position d’objectivation et se placer avec le patient dans une relation de vivant à vivant et de sujet à sujet » (Lefève et Mino, 2011). 3.3. Spécificités de la relation thérapeutique et questions ouvertes sur l’évaluationS’agissant des activités adressées à autrui, Maubant et Piot (Maubant et Piot, 2011) relèvent combien elles supposent de pouvoir identifier la singularité des situations et la nécessité d’y agir avec une certaine autonomie. Dans ces activités, la dimension observable, objectivable, n’est qu’une manifestation partielle de toute une activité invisible, consistant à « percevoir des informations pertinentes, les organiser et les interpréter pour leur donner du sens, prendre des décisions, vérifier l’adéquation des effets réels de l’activité avec les effets attendus et le cas échéant, mettre en place des processus de régulation » (Ibid., p. 9). Les termes utilisés tels que savoir-être, comportement, attitude, capacité relationnelle, compétence sociale, etc. résistent à une définition en tant qu’objet d’apprentissage pour « ce qui est généralement conçu comme des qualités humaines attribuées à des traits de personnalité souvent considérés implicitement comme innés » (Hébrard, 2011), alors qu’il s’agit de qualités socialement construites, et donc culturellement formées. Selon cet auteur, les « zones d’ombre » auxquelles se heurtent ces apprentissages tiennent « au flou des cadres conceptuels sous-jacents, à l’influence d’un paradigme issu du behaviorisme et du pragmatisme », et « à l’insuffisance de la réflexion épistémologique et du questionnement éthique » (Ibid., p. 107). Etudiant les référentiels de compétence et de formation, notamment les grilles d’évaluation, Hébrard constate que la complexité de la relation humaine tend à être « réduite à sa surface communicationnelle et à l’utilisation de ‘techniques’. La profondeur et l’ambiguïté, les enjeux identitaires, sociaux, politiques et éthiques semblent occultés ou du moins mis au second plan » (Ibid., p. 113). Les formateurs se trouvent pris dans la tension entre des supports très prescriptifs et détaillés, qui notamment rigidifient l’évaluation, et l’affirmation de l’autonomie et de la responsabilité des étudiants, en ce qu’ils doivent savoir appréhender chaque situation dans sa singularité et sa globalité. Il apparaît que les orientations adoptées en termes de formation et d’évaluation ont des liens avec la conception retenue de l’activité thérapeutique : si les compétences cliniques reposent non seulement sur la connaissance des pathologies et des moyens d’investigation et de traitement, mais, de façon imbriquée, sur « la compréhension fine de ce que peut signifier le fait d’être malade pour un individu et son entourage, ainsi que la connaissance des enjeux sociaux et institutionnels de cette expérience » (Lefève et Mino, 2011), alors les situations de relation soignant-patient sont fondamentalement des situations qui réclament une réflexion sur et dans l’action, et une réflexion menée non sur le patient mais avec lui. Dès lors il apparaît qu’une opération qui paraît aussi simple que de définir des listes de critères d’évaluation est en fait sous-tendue par une conception plus générique de ce qu’est, en l’occurrence ici, un thérapeute. Une approche par compétences ramenée à une liste d’attitudes peut s’avérer converger avec une approche objectivante des patients et instrumentale des relations, précisément parce qu’elle n’interroge pas les dispositions requises pour être à même de mener ce double mouvement d’objectivation et de construction d’un échange effectif avec un patient. La démarche des ECOS est également répandue dans les pays anglo-saxons avec ses checklists et ses patients-standardisés. Elle apporte certes l’individualisation de l’apprentissage mais revient selon certains auteurs à démontrer la performance de l’étudiant, et ce, potentiellement au détriment du processus sous-jacent (Leung, 2002). L’approche peut être perçue comme superficielle et parfois source de démotivation. Elle encourage les étudiants à faire ce qu’on attend d’eux plutôt que de prendre le risque de développer une distance critique. A cela s’ajoute le risque pour les examinateurs de définir des règles minimalistes de validation. L’autre risque souligné par Leung, la réduction du contenu pédagogique, est particulièrement sensible dans le contexte d’études médicales où les étudiants désertent les cours magistraux et où le primat donné aux QCM fait que toute évaluation doit se conformer aux modalités d’un QCM, quand bien même les connaissances en cause sont complexes et relèvent d’un paradigme différent de celui de l’evidence-based medicine, ce qui est le cas des connaissances issues des sciences sociales. Il résulte de ces éléments qu’il apparaît particulièrement important de mener une réflexion approfondie, en valorisant la réflexivité de la démarche d’innovation pédagogique retenue et de l’environnement informatique qui lui sert de socle. Le risque a contrario serait de plaquer des conceptions instrumentales des compétences et de leur évaluation aux activités et relations thérapeutiques. Des pistes d’évolution intéressantes pourraient être trouvées dans une approche plus transversale, intégrant notamment les mises en situation en stage et dans des évolutions de l’EIAH incluant une participation plus active des étudiants. 4. Conclusion et perspectivesCette communication rend compte des premiers résultats d’une démarche innovante en termes de formation aux compétences cliniques de futurs médecins et de leur évaluation. L’environnement informatique constitué permet d’une part d’équiper l’ingénierie pédagogique, et d’autre part, distinctement, de recueillir de façon anonyme les retours tant des enseignants que des étudiants. L’étude des résultats de cet examen de compétences cliniques montre qu’il n’est pas redondant au regard des examens évaluant les compétences plus « théoriques » sur les maladies, les techniques diagnostiques et thérapeutiques et les sciences dites fondamentales associées. En cela, cet examen présente une contribution spécifique, dont la pleine signification reste à expliciter. L’analyse critique proposée en complément permet d’ouvrir des pistes sur les questions que soulève cet examen. L’observation du dispositif en train de se faire permet d’interroger les paradigmes en présence. Il apparaît que, compte tenu des impératifs de calendrier et de conceptions implicites sur les relations soignants-patients, l’approche behavioriste ait été dominante dans les premiers temps de ce dispositif. En perspectives, la question est celle de dispositifs complémentaires ou renouvelés de formation et d’évaluation qui fassent place à une approche constructiviste susceptible d’aider à affronter des situations qui réclament une réflexion sur et dans l’action (Boutin, 2000). Dans cette perspective, la refonte des stages et de leur évaluation pourrait être l’occasion d’une réflexion sur la mise en place de démarches pédagogiques et d’évaluation accordant plus de place à cette réflexion sur et dans l’action, non seulement sur, mais aussi avec les patients. Il s’agit également de réfléchir à un dispositif permettant de mesurer la progression des compétences acquises au fil du cursus, voire au-delà si une articulation peut être établie avec la formation du troisième cycle voire la formation continue des praticiens. Dans ce cadre, l’EIAH doit permettre de mesurer la progression des compétences acquises en cours de formation et de contribuer à la réingénierie pédagogique, tout en étant lui-même objet d’enquête et de réflexion dans la perspective interdisciplinaire retenue. REMERCIEMENTSCette recherche est financée grâce au soutien de l’Institut de Recherche en Santé Publique, IReSP-17-HSR-16. Elle a bénéficié de l'aide des partenaires financeurs de l'IReSP dans le cadre de l'appel à projets général 2017 Volet Services de Santé. J.C. Basson (CRESCO EA 7419*), E. Coeurdevey (CERTOP UMR 5044*), E. Fournales (CERTOP UMR 5044*), N. Haschar-Noé (CRESCO EA 7419*), P. Marrast (CERTOP UMR 5044*), T. Lang (INSERM UMR 1027**), M. Kelly-Irving (INSERM UMR 1027*), S. Lamy (INSERM UMR 1027*), L. Bonneville (GRICO**) et S. Grosjean (GRICO**), participent également à cette recherche dans le cadre d’une collaboration menée au sein de l’IFERISS, Institut Fédératif d’Etudes et de Recherches Interdisciplinaires Santé Société. * Université Toulouse 3 ** Université d'Ottawa

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Référence de l'article :Olivier CATTEAU, Anne MAYÈRE, Nicolas SAVY, Odile BEYNE-RAUZY, Équiper et évaluer un « certificat de compétences cliniques », Revue STICEF, Volume 27, numéro 2, 2020, DOI:10.23709/sticef.27.2.1, ISSN : 1764-7223, mis en ligne le 02/02/2021, http://sticef.org |

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

© Revue Sciences et Techniques de l'Information et de la Communication pour l'Éducation et la Formation